背景

之前跟 LLM 对话过程一直有个痛点,虽然我可以使用例如 FireCrawl/Tavis 这样的工具扩展 LLM 的能力,但是涉及到具体 某个项目的 Code Understanding 相关任务 的时候,不管是自建还是封闭 LLM 对话服务基本都无能为力,一般做法就是乖乖找台电脑,拉取代码到本地再使用例如 Cursor 等工具辅助分析,但一是麻烦,二是过度依赖完整桌面环境。

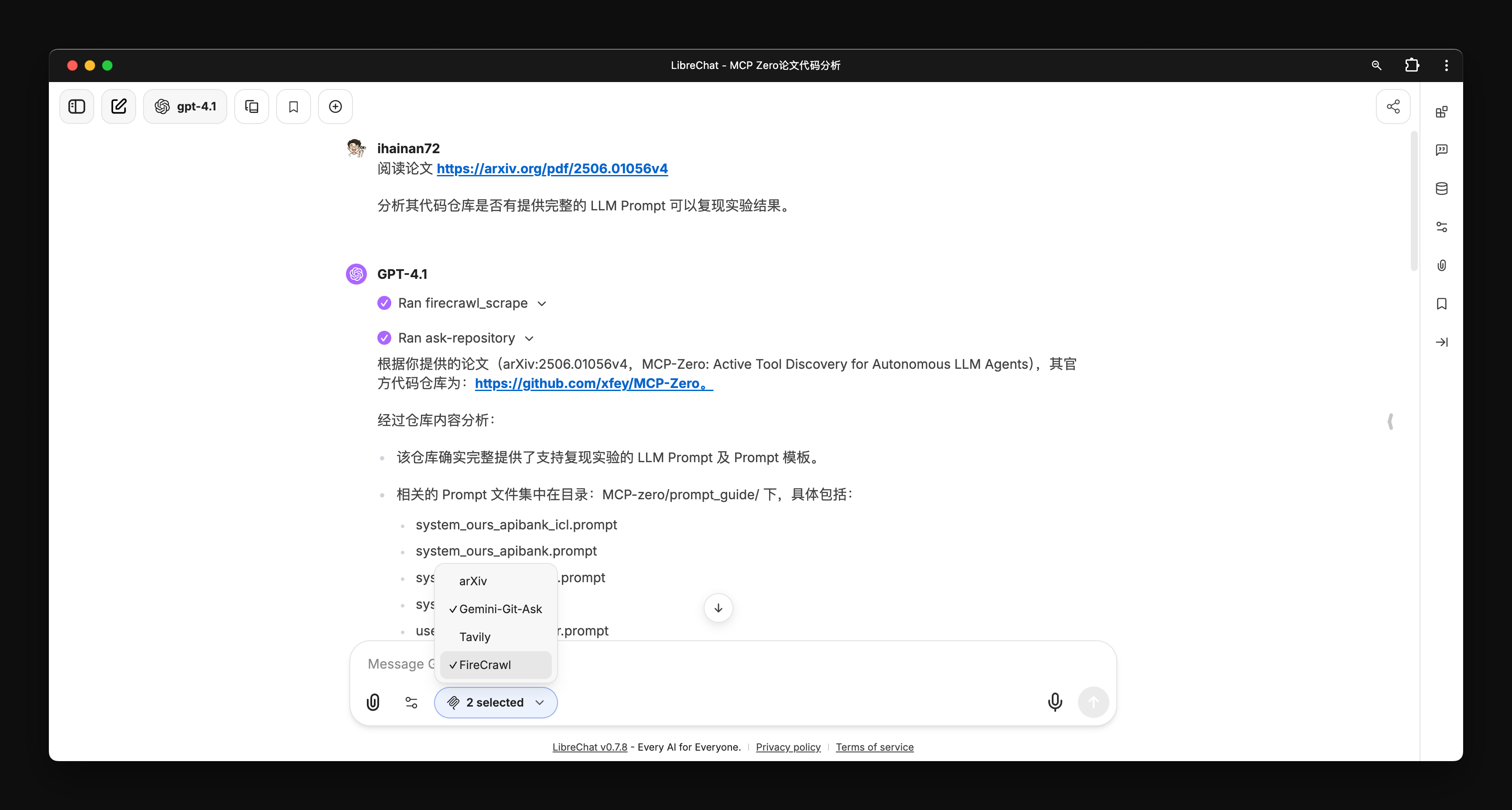

我自己目前正在开发的 AI Paper Assistant 应用,面对有开源实现的论文,虽然我添加了 MCP 的支持,但LLM 回答的范围也仅局限于论文本身和搜索引擎结果,想研究代码实现依旧还是得走前面的老路子,糟心。

Gemini CLI 的出现算是半解决了我的痛点(以及 Gemini 2.5 Flash 几乎可以无限用也是利好我这个穷人),不再依赖于桌面系统和图形化界面,但是跟现有 LLM 对话应用的集成依旧是个问题,其次在移动端 SSH 连接使用 Gemini CLI 的体验也十分差劲。

好消息是 Gemini CLI 提供非交互模式,可以自定义 Prompt、模型和上下文策略(但是不能调温度、max_tokens 等参数),这意味着我们可以在不修改源码的基础上,直接调用本地的 Gemini CLI 来封装 API。

1 | # ihainan @ debian-dev in ~/extend/projects/Research/gemini-cli on git:main x .venv [15:04:18] |

解决痛点的第一步,先把 Gemini CLI 基于任意 Git/GitHub 实现问答的功能实现了,所有便有了 Gemini-CLI-Git-Ask 这个项目。

RESTful API

实现的功能很简单,首先是 RESTful API 调用:

1 | # ihainan @ debian-dev in ~ .venv [14:51:30] |

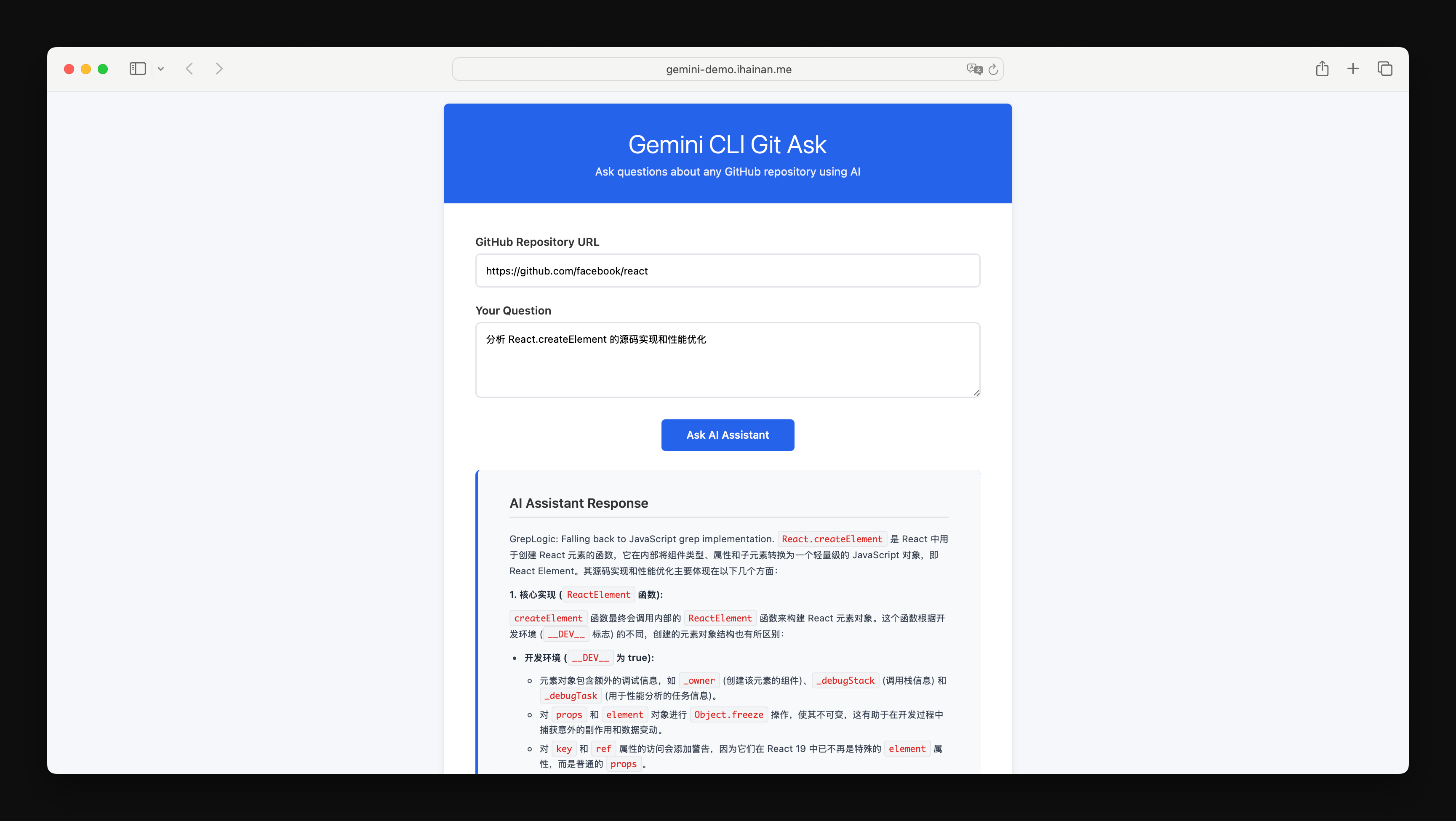

上线一个 Live Demo,提供 Git/GitHub Repo URL 和问题,点击回答,稍等一会即可获得解答。后端对接的是 Gemini-2.5-Flash。

MCP Server

在 RESTful API 的基础上继续构建 MCP Server,目前只提供了一个 Tool ask-repository,接受下面三个参数:

- repository_url

- question

- branch (optional)

已经上传 NPM,直接 NPX 安装/运行即可:env SERVICE_URL=http://<your_IP_address>:18080 npx -y git-ask-mcp-server。

然后就可以在 LLM 对话应用里面对接 MCP Server 了。

其他

这次 Vibe Coding 稍微让整个流程更为可控一些,每个模块下面都有一个单独的设计文档,单元/集成测试也有完整的状态追踪文档,Git commit message 也设置了规范并通过 Cursor Rules 要求 LLM 遵循。后续开发的过程每实现一个功能就会更新相应的文档。

此外也尝试把用到的重要提示词也做了记录,Cursor 并没有 Chat History 导出功能,所以先暂时手工维护放到了 Chat History 目录下面。